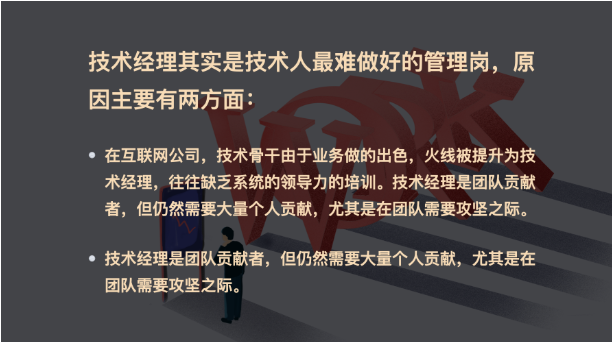

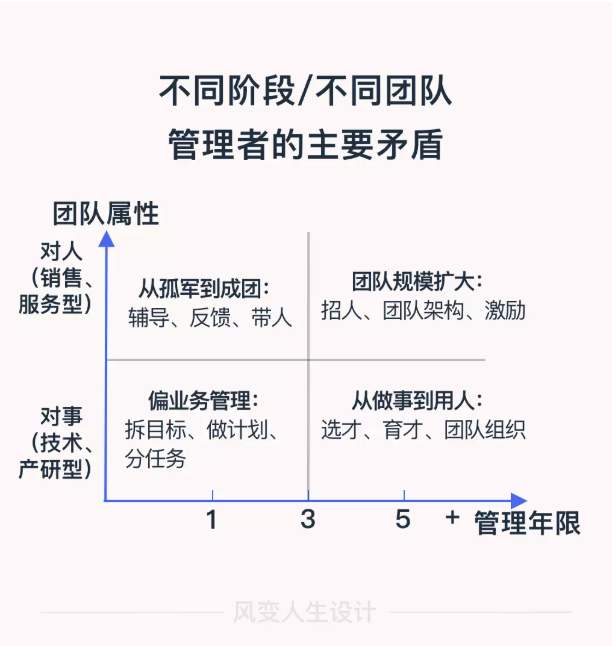

技术人转管理的第一步就是能胜任「技术经理」。

这两方面原因,导致技术经理之路,非常艰难。技术人要做好技术经理,有很多很多学问、知识、经验和技巧。但其中最关键的,是四个重要跃升。

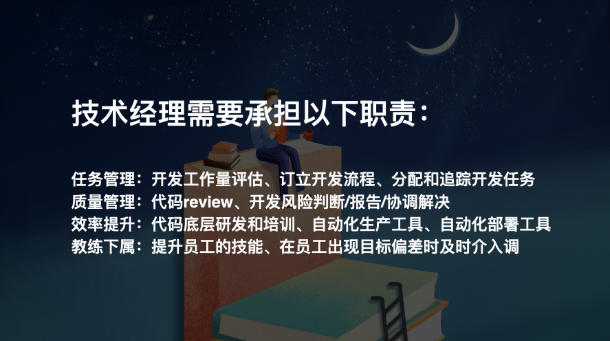

技术经理管理个人贡献者:技术骨干和员工。

而技术总监/CTO管理团队贡献者:技术经理和架构师。

管理对象的变化带来的是责任的跃迁。

技术经理更关注实现细节和进度,在关键节点需要攻坚。

而高阶管理者的团队一般都在50人以上,这种情况下不应该过分关注细节,需要更多关注平台建设,还需要充分授权。

很多同学,在刚担任技术经理时,团队遇到技术困难,习惯于上阵去解决。

问题是解决了,回头发现团队的产出反而慢了。原因很简单,关键的技术决策、规划、资源协调、经理下属的培养等工作都被耽误了。

管理者需要对团队业绩负责。当团队规模变大,除非问题真的只有你能解决,否则不能轻易陷进去。承担新的责任,很重要。

技术经理往往负责单一产品线,而高阶管理者负责整条业务线。这种差异决定了技术经理在晋升高阶管理者之前必须先实现业务跃升。

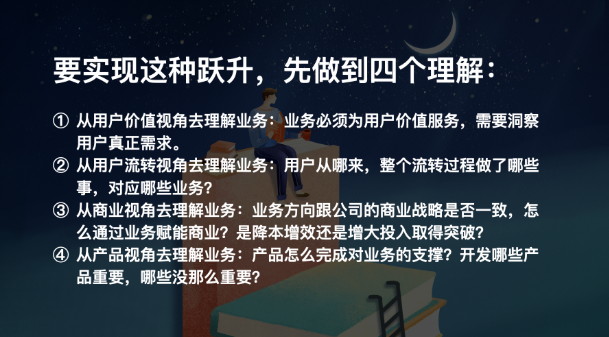

要实现这种跃升,先做到四个理解:

从用户价值视角去理解业务:业务必须为用户价值服务,需要洞察用户真正需求。

从用户流转视角去理解业务:用户从哪来,整个流转过程做了哪些事,对应哪些业务?

从商业视角去理解业务:业务方向跟公司的商业战略是否一致,怎么通过业务赋能商业?是降本增效还是增大投入取得突破?

从产品视角去理解业务:产品怎么完成对业务的支撑?开发哪些产品重要,哪些没那么重要?

这四个理解,又可以称为:业务洞察力。

跟大家分享一个一位技术管理者之前跟我分享故事,做自动化解决方案的,他们遇到了一个问题,得出一个重要结论:90%的远程控制工作可由自动化方案解决。随后这位同学带领团队研发了一套和AI结合的远程修电脑的方案。

通过技术实现自动化方案,首先通过AI自动回复及分析,拦截50%无效用户问题。之后自动分析用户电脑情况,运行自动化AI修复软件。还解决不了的,才由工作人员人工解决。

这套解决方案,让工作人员每天处理的用户量提升了10倍。

原本需要500人的运营团队,只需要50人,给公司节约了巨额的运营成本。

这是一次基于对业务深刻的洞察进而提升业务效率的实战。技术管理者,需要提升对用户的理解、具备基础的商业知识和一定的产品能力。并将这些能力应用到对业务的驱动中,最终培养出卓越的业务洞察力。

这就是第二个重要的跃升:业务跃升。

具备战略决策能力。而什么是战略决策能力?

战略决策能力不是有很多天才idea,每个idea都可以颠覆世界。比决定做什么更重要的是你能决定不做什么。

只有真正理解了用户、业务、商业、产品,才能做出最重要的关键决策。进而才能具备战略决策能力。

技术团队是成本团队,资源用在哪,资源投入的多少,都需要决策。

拿阿里举例:阿里要求P9管理者要具备一年的战略决策能力,P10要具备三年的战略决策能力。

2018年,我加入哒哒少儿英语,负责dadababy项目。

老板交给大家一个业务目标:半年实现0投放实现100万用户。如果是你,你会怎么做?

比如可以分析了行业数据和竞争对手的数据,然后找出多个可以做突破的方向。

再之后可以结合团队的优势只选择了一个方向做战略单点突破。将游戏化做到极致。为了提升游戏生产质量和生产速度,我们集重兵做了一个高效的游戏编辑引擎。

越是高阶的技术管理者越需要面对更复杂的沟通环境。

1.跨部门/公司沟通

高阶技术管理者需要和不同部门协调资源、推进合作、判断需求,有时候可能还要做跨公司的沟通。

这个过程,真正理解其他部门/公司的需求非常重要。有时候,技术人和其他部门的同事会有沟通困难的感觉,甚至相互都觉得对方不能理解自己。其实往往是沟通语言上出了问题,技术管理者要学会用非技术语言去沟通。

2.跟老板沟通

前几天,和几个做安全的技术VP聊天,大家谈到一个问题:企业的安全投入力度怎么控制。

一个朋友说了这么一段话:安全防护这件事很头疼,不出事老板觉得团队没什么价值,出事了老板也会觉得团队没什么价值。

其实不仅是安全团队,只要是技术支撑型团队,遇见不是技术出身的CEO,都有可能存在这种困境。

大家讨论了半天,最后结论是:这必须有一个能向上做好管理的CTO。

他需要能用老板听得懂的语言,告知投入的必要性,并获得老板的支持。

技术管理者,如果不能做到和老板的良好沟通,结局一般都会暗淡出局。

这就是第四个重要的跃升:沟通跃升。

总结一下,做好技术管理,一共有4个非常重要的跃迁。

第一个跃升,叫做责任跃升。

你要根据管理的团队大小,调整自己的职责。

第二个跃升,叫做业务跃升。

你要真正具备用技术驱动业务,进而驱动商业的能力。

第三个跃升,叫做战略跃升。

你要脱离技术本身,站在产品、用户、商业、业务视角,做好技术战略决策。

第四个跃升,叫做沟通跃升。

你要具备能和非技术人员良好沟通的能力,尤其是老板。

只有经历了这四个跃升,在技术管理这条泥泞之路上,你才能走得顺走得稳